Jason Lewis segítségével áttekintést kapunk az Nvidia jelenleg csúcskategóriás gaming GPU-járól, összehasonlítva azt a cég GeForce és Titan RTX grafikus kártyájának teljesítményével real world 3D és GPU render tesztek segítségével.

Ha a CG Channel rendszeres olvasója vagy, akkor talán emlékezhetsz arra a tavalyi csoportos GeForce, Titan és Quadro RTX GPU tesztre, melyben Jason bemutatta, hogy hogyan kezelik a 3D szoftvereket az Nvidia legújabb Turing grafikus kártyái. A sorozat folytatásaként most egy olyan GPU-t tesztel, amely az első körben kimaradt, nevezetesen az Nvidia jelenleg csúcskategóriás felhasználói kártyáját, a GeForce

RTX 2080 Ti-t. A következőkben Jason-t idézzük:

"Látván az RTX 2080 Ti teljesítményét a DCC alkalmazások reprezentatív skáláján, megvizsgálom, hogy az Nvidia RTX hardvere milyen mértékben képes felgyorsítani a GPU rendert, ezután pedig megválaszolom azt a néhány kérdést, amelyet az olvasók az előző bejegyzésemre válaszul feltettek: Mennyire fontos a memória kapacitása a GPU kiválasztásakor produkciós munka során, valamint mennyire fontos az Nvidia Studio GPU illesztőprogramjainak használata?

Összehasonlításképp újra fogom tesztelni a tavaly kipróbált felhasználói, illetve produkciós munkára szánt kártyákat az újgenerációs Titan RTX és a GeForce RTX 2080-at, valamint az előző generációs GeForce GTX 1080 és GeForce GTX 1070-t.

A Titan V-t ezúttal nem vontam be a tesztelésbe, mivel az eredeti tesztjeim azt mutatták, hogy a Titan RTX egyrészt jobban teljesít DCC munkák során, másrészt olcsóbb is, valamint egy következő tesztelésben szeretnék még visszatérni az Nvidia workstation grafikus kártyáihoz, a Quadro RTX szériához.

Sajnos nem volt alkalmam tesztelni az Nvidia alacsony vagy közepes kategóriájú GeForce RTX kártyáit, a GeForce RTX 2060 és 2070 –et. A teszt során használni fogom 3DMark-ot, ennek segítségével összehasonlíthatod az eredményt a korábbi tesztek során kapott pontszámokkal, melyek online elérhetőek.

Mielőtt belevágnánk a tesztelésbe, röviden áttekintünk néhány technológiai kifejezést, amelyekkel az előző áttekintésben foglalkoztam. Ha már ismered őket, akkor érdemes ezt a részt átugrani.

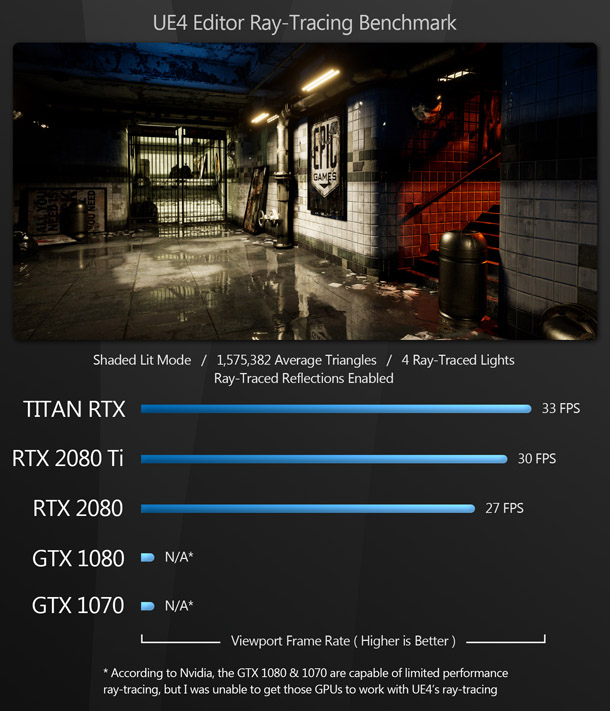

Az Nvidia jelenlegi generációs Turing GPU architektúrája háromféle processzormaggal rendelkezik: CUDA – általános GPU, Tensor - gépi tanulási műveletekhez, és az új RTX kártyákban megtalálható RT mag – a raytracing (fénykövetés, árnyékvetés) műveletek felgyorsításához. Az RT magok előnyeinek kihasználása érdekében a szoftveralkalmazásoknak grafikus API-n keresztül kell a magokat elérnie. Ebben a beszámolóban a DXR-t (DirectX Raytracing), melyet Unreal Engine -ben használnak, valamint az Nvidia OptiX API-ját használom, amelyeket az offline renderelők

többsége használ. Ezekben a render motorokban az Optix rendering backend alternatívaként szolgál a régebbi Nvidia’s CUDA API-ra. A CUDA API-k az Nvidia GPU-k szélesebb skálájával működnek, de az OptiX lehetővé teszi az RTX kártyák RT magjai által felgyorsított raytracinget, amelyet gyakran egyszerűen „RTX gyorsításnak” neveznek.

Habár számos gyártó kiadja a GeForce RTX 2080 Ti saját változatát, ebben a tesztben az Nvidia kártyáját használtam. Leszámítva a RTX-et - mely félúton helyezkedik el a játékra- és munkára szánt kártyák között - ez az Nvidia jelenleg csúcskategóriás felhasználói GPU-ja.

A 2080 Ti és a Titan RTX hasonló specifikációkkal rendelkezik. Mindkettő az Nvidia Tu102 GPU-ját használja, 1350 MHz-es alap órajellel, bár a Titan-nak magasabb a boost-olt órajele: 1.770MHz,szemben az 1.545MHz-rel, vagy az 1.635MHz-rel. A Titan Tu102 4,608-os CUDA maggal, 576-os Tensor maggal és 72-es RT maggal, míg a 2080 Ti kissé gyengébb verziója 4,352-es CUDA maggal, 544-es Tensor maggal és 68-as RT maggal rendelkezik.

A legnagyobb különbség a kártyák között az a GDDR6 RAM memória mérete. A 2080 Ti 11 GB RAM-mal rendelkezik a Titan 24 GB-jával szemben, mely a 2080 Ti több, mint kétszerese. Az ár ennek arányában változik: a 2080 Ti aktuális ára körülbelül 1200 dollár; a Titan körülbelül 2500 dollár.

Az alábbi táblázatban megtekintheted a korábban tesztelt kártyák, a GeForce RTX 2080, a GeForce GTX 1080 és a GeForce GTX 1070 specifikációit, IDE kattintva pedig további információkat olvashatsz a kártyák előnyeiről és hátrányairól.

Az előző tesztekhez hasonlóan BOXX Technologies APEXX T3 gépet használtam (128GB 2666MHz DDR4 RAM, a 512GB Samsung 970 Pro M.2 NVMe SSD, 1000W-os tápegység) amit egy AMD Ryzen Threadripper 2990WX CPU-t futtatott.

A teszteléshez a korábbi cikkben használt alkalmazások egy részét vettem elő újra, egyes esetekben a szoftverek aktuális verzióira frissítve. A benchmark-ok Windows 10 Pro oprendszerendszeren futottak, és négy kategóriába soroltam őket:

Teljesítmény megjelenítés és számítás közben

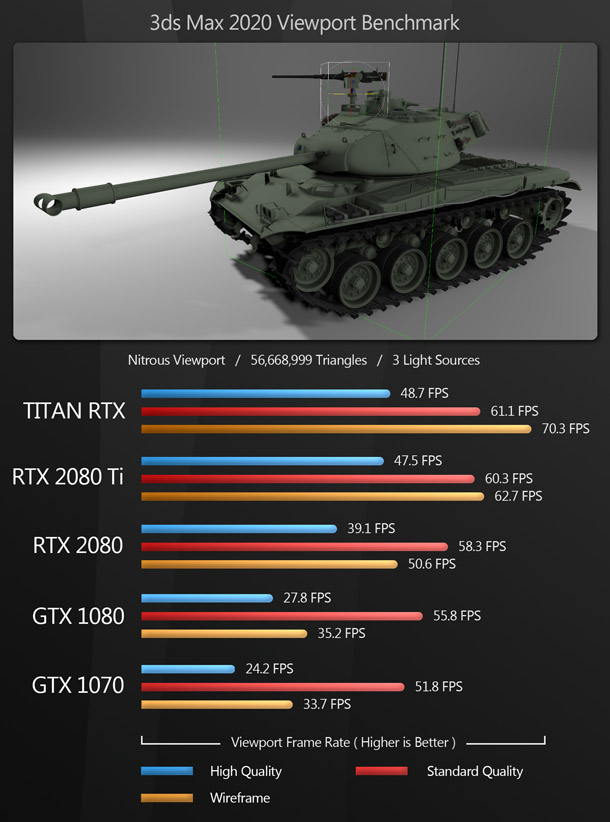

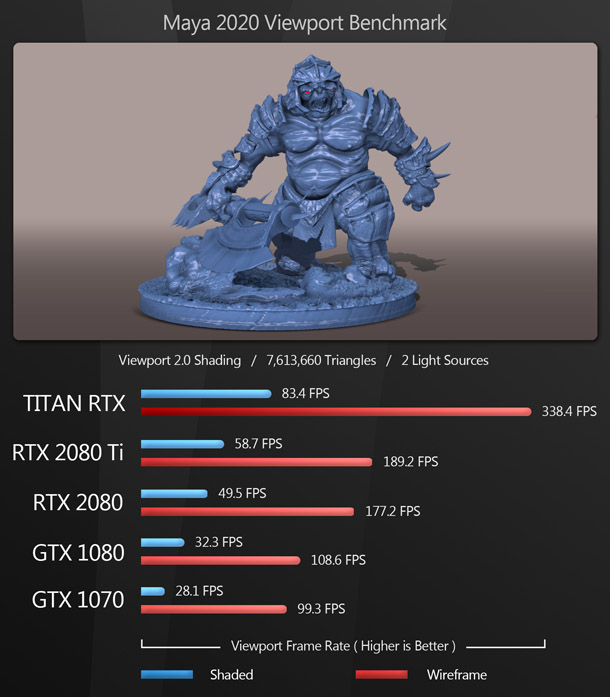

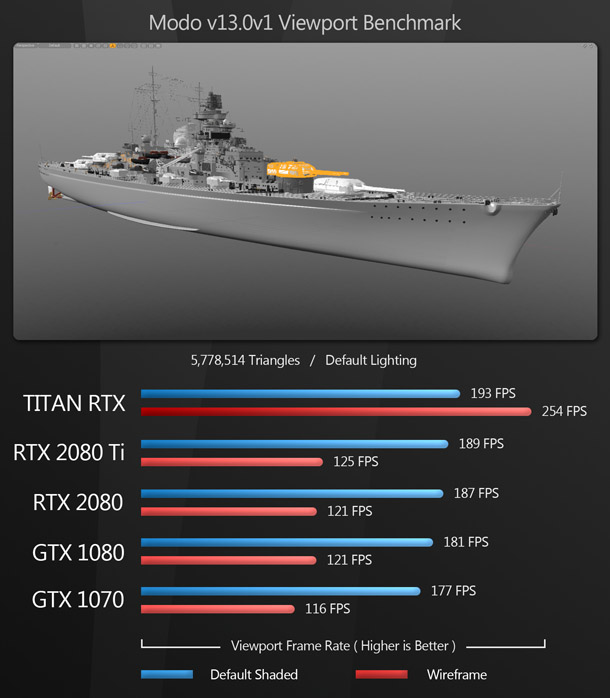

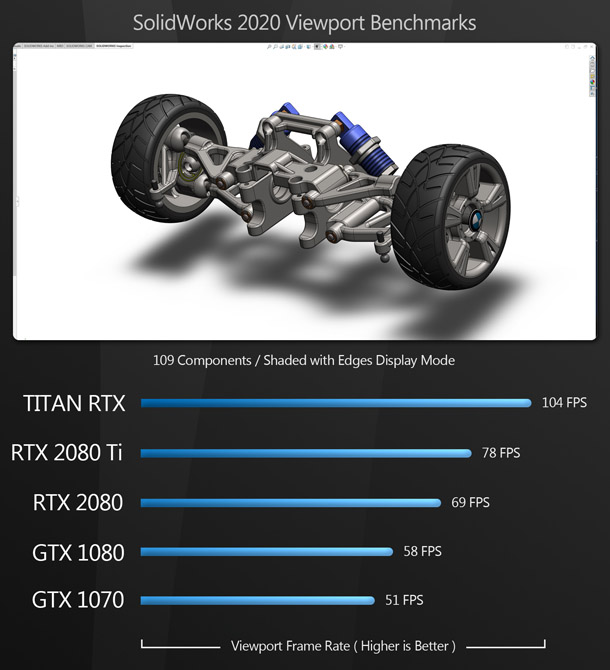

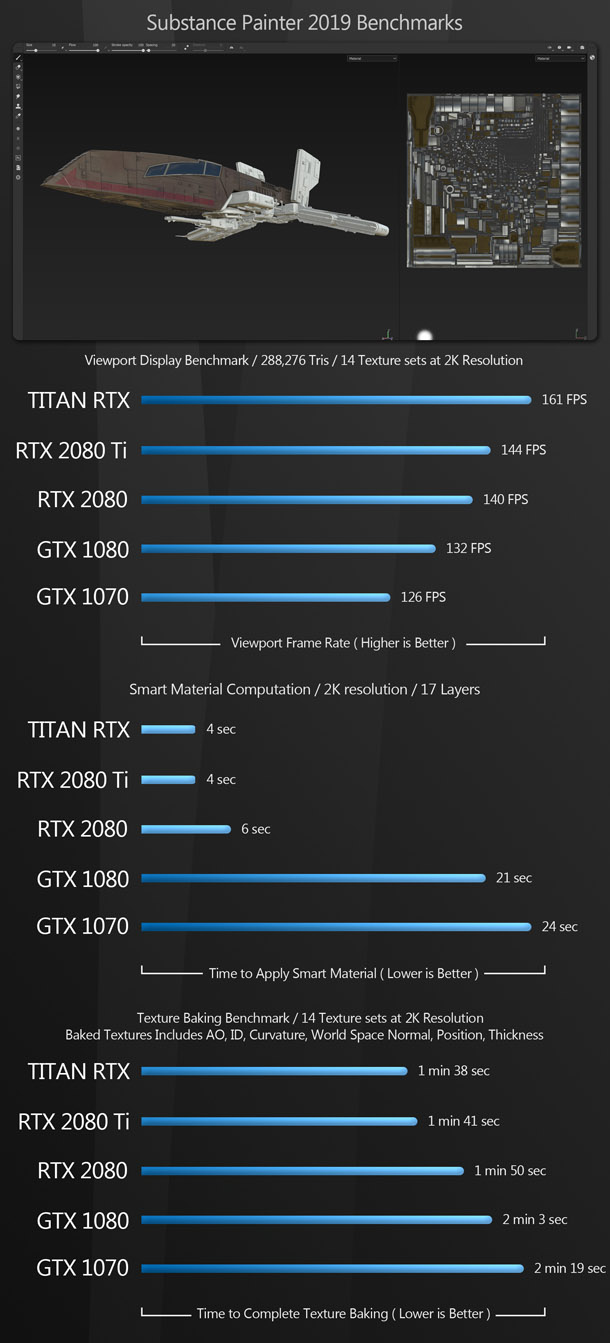

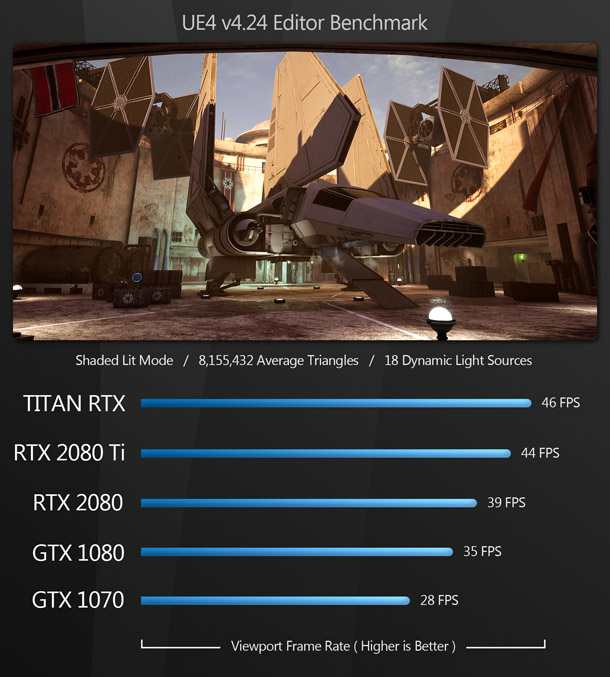

Ebbe a csoportba számos kulcsfontosságú DCC alkalmazás tartozik, általános célú 3D szoftverek, 3ds Max, Blender és Maya. Ezen kívül speciális tool-ok is, mint például a Substance Painter, SolidWorks CAD package, valamint az Unreal Engine.

Ahogy az várható volt, a Titan RTX az összes tesztben az első helyet foglalja el, az RTX 2080 Ti -jal szorosan mögötte, kivéve SolidWorks -ben, ahol a Titan fölényesen vezet. Az RTX 2080 a harmadik helyen áll az összes tesztben, őt követi a GTX 1080 és a GTX 1070.

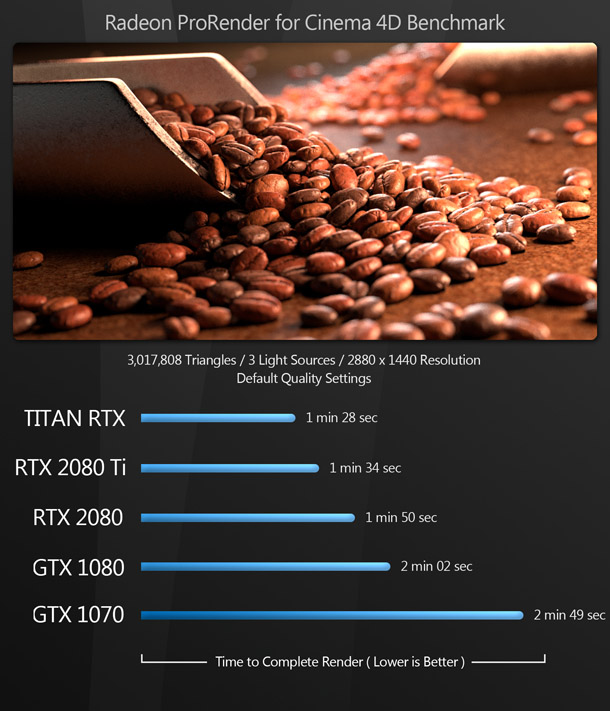

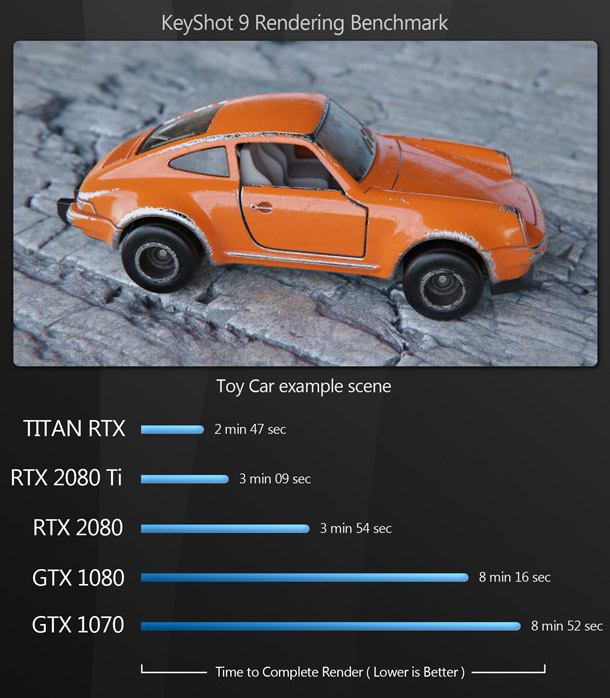

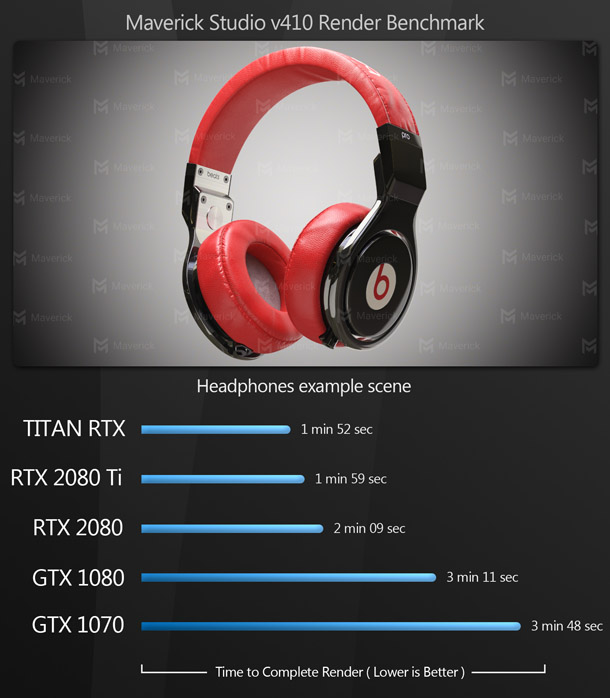

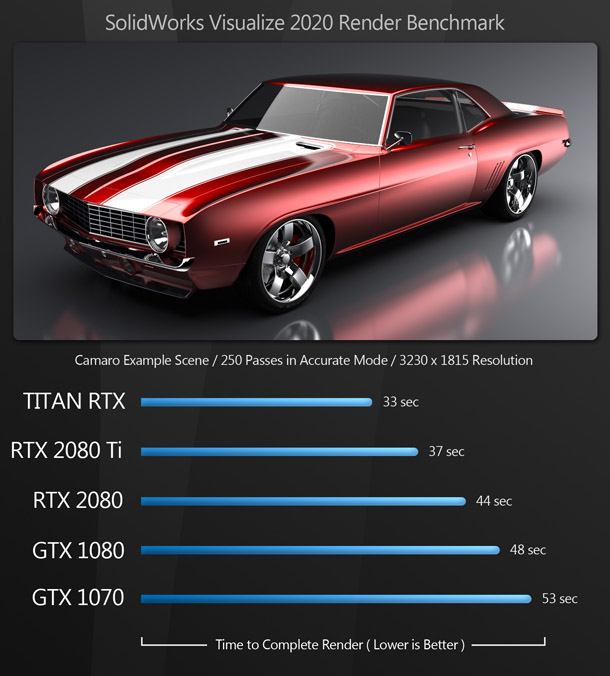

A rendering benchmark -okat két csoportra osztottam. Az első csoportba tartozó szoftverek vagy nem használják az OptiX-et raytracing-hez, vagy nem teszik lehetővé az OptiX-háttér be- és kikapcsolását, így sajnos nem lehet felmérni az RTX gyorsítás hatását a teljesítményre.

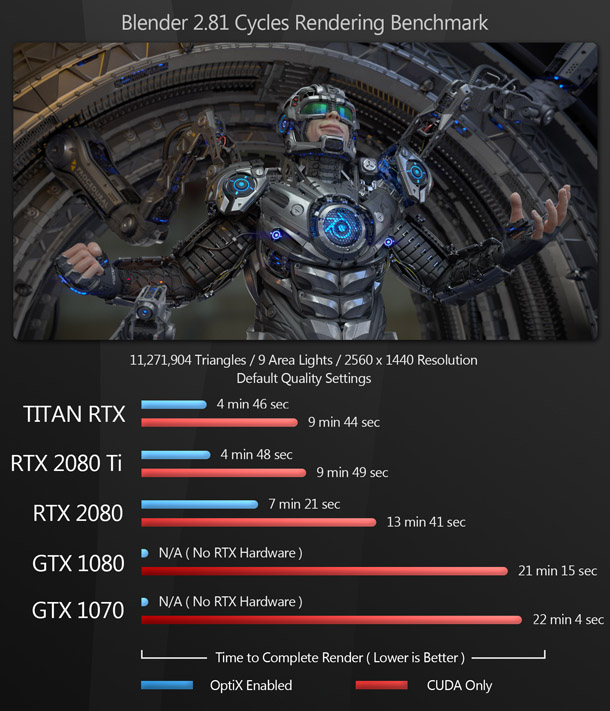

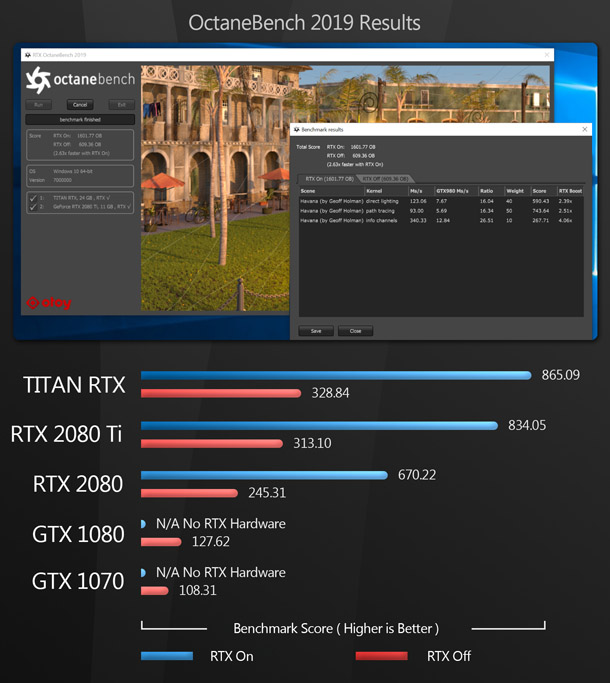

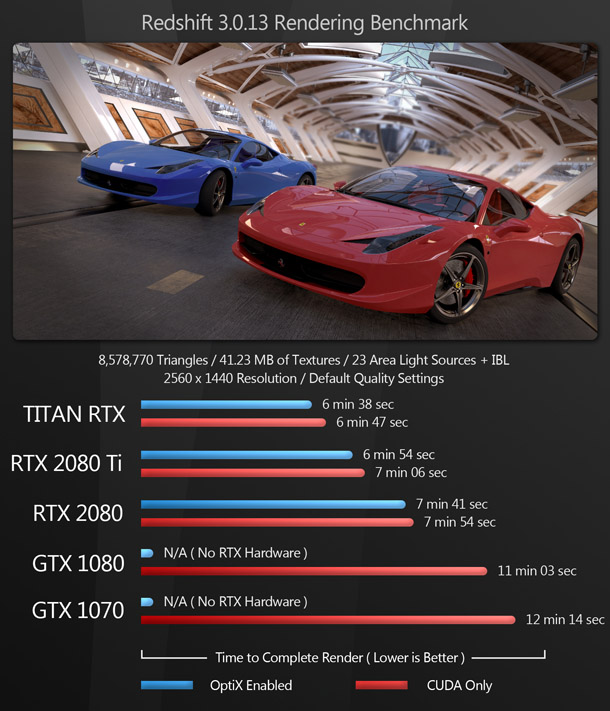

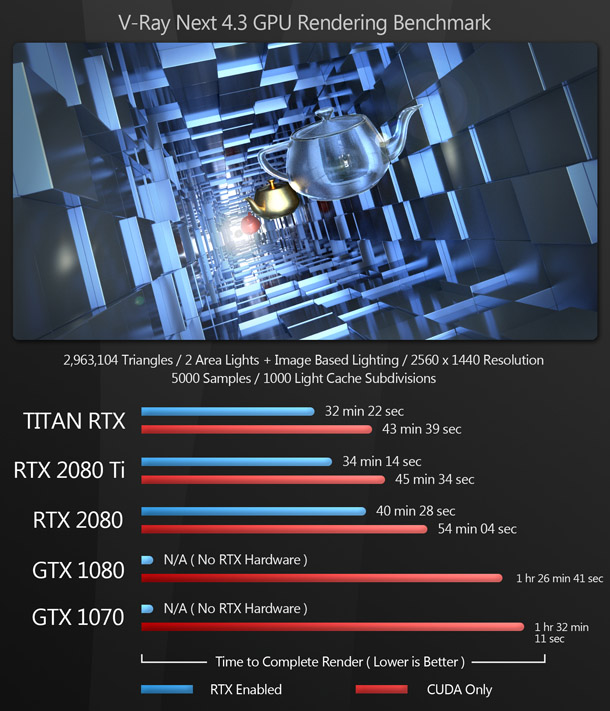

A második csoportba tartozó alkalmazásoknál már lehetővé válik az OptiX engedélyezése vagy a CUDA használata, így a teljesítménynövekedés mérhető, ha az RTX gyorsítás engedélyezve van.

A 3D-s megjelenítéskor elért teljesítményekhez hasonló eredményeket hozott a GPU rendering közben elért teljesítmény is: első helyen a Titan RTX , bár az RTX 2080 Ti nagyon szorosan követi. A sima RTX 2080 harmadik helyen áll, amelyet a GTX 1080 és a GTX 1070 követ.

Érdekes látni, hogy hogyan növekszik a teljesítmény, ha az OptiX engedélyezve van, és a szoftver bevonhatja a raytracing műveletekhez az RTX kártyák RT magjait is.

Redshift esetében ez a hatás viszonylag kicsi – bár érdemes megjegyezni, hogy a 3.0 verzió még csak nemrég jelent meg. A teljesítmény V-Ray-ben a 33-35% -kal, a Blender-ben pedig 85-105% -kal növekedett.

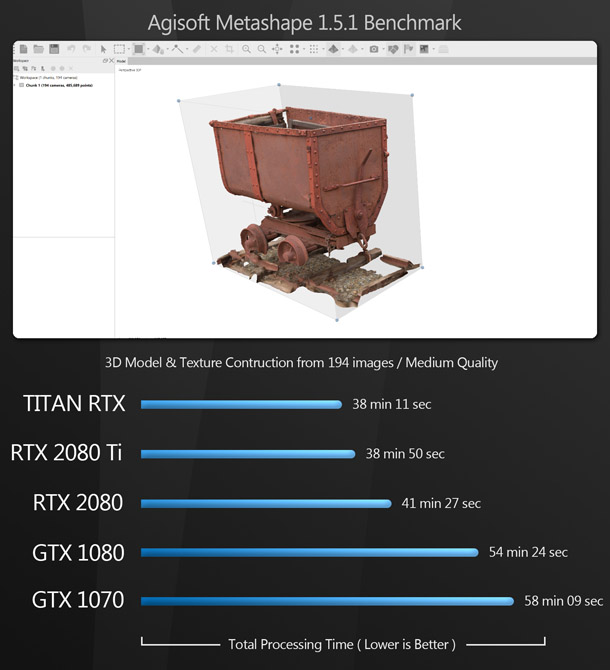

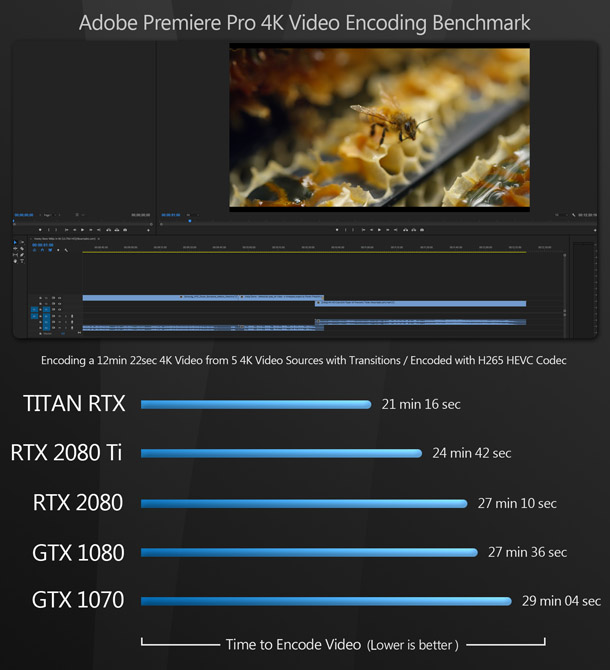

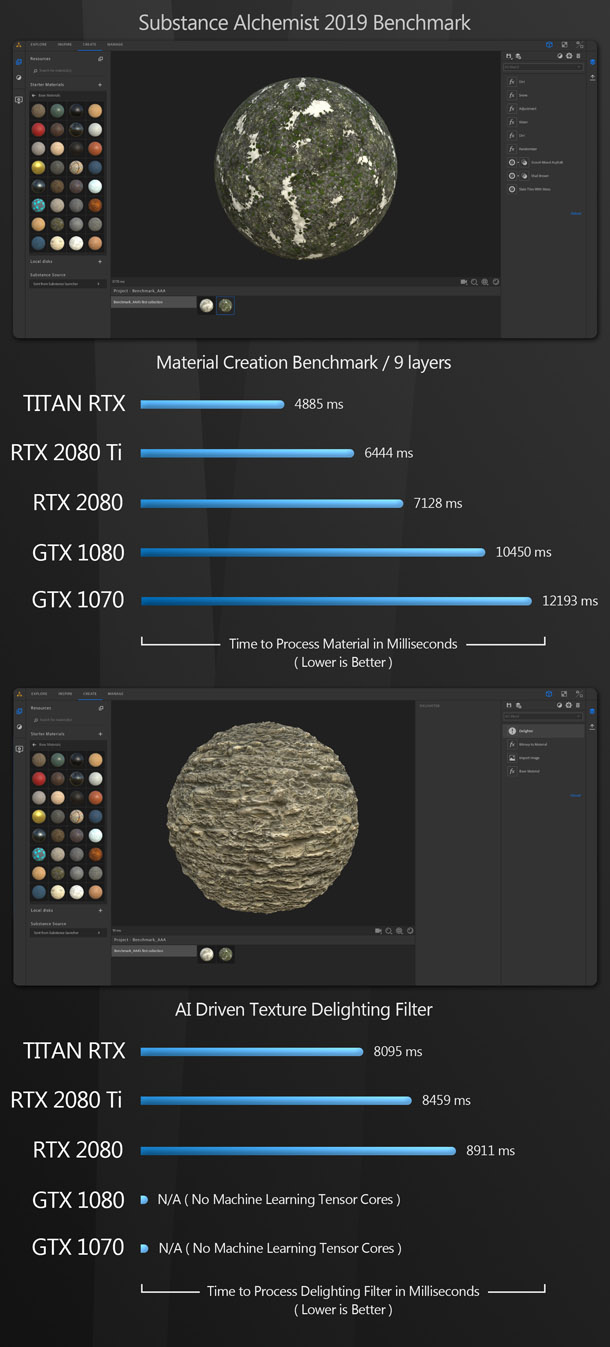

A következő benchmark csoport célja a GPU használatának tesztelése a speciálisabb feladatok elvégzéséhez. A Metashape (fotogrammetriai alkalmazás) - a GPU-t képfeldolgozáshoz használja, a Substance Alchemist textúra készítéshez és bizonyos szűrők futtatásához, a Premiere Pro pedig a végleges, szerkesztett videók kódolásához.

Az előző értékekhez hasonlóan a Titan RTX az összes tesztben első helyen áll, sorrendben követi a az RTX 2080 Ti, az RTX 2080, a GTX 1080 és a GTX 1070. A teljesítménybeli eltérések a Premiere Pro esetében a legkisebbek, a Substance Alchemist esetében pedig a legnagyobbak.

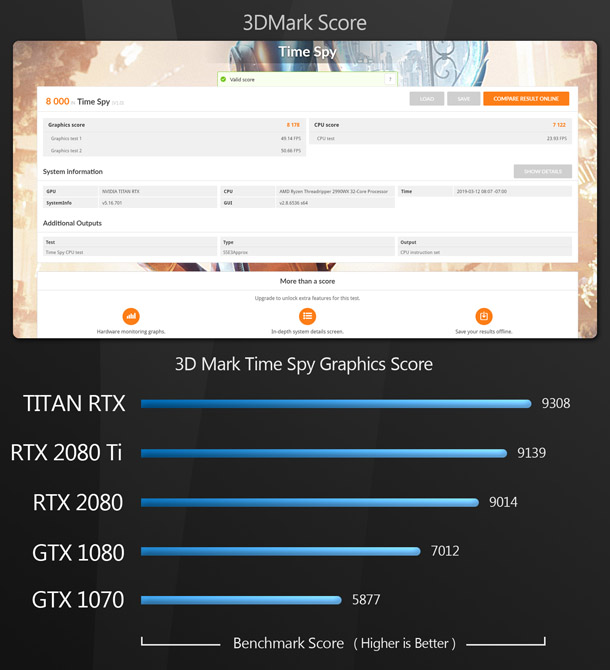

A szintetikus tesztek nem tudják pontosan megjósolni a GPU teljesítményét munka közben. Mivel GPU-k széles kálájához elérhető pontszámok vannak az interneten, ez lehetővé teszi a tesztelt kártyák összehasonlítását más modellekkel. A korábbi tesztektől eltérően Cinebench-et nem említettem, mivel a legutóbb 6 éve jelentettek meg GPU benchmark-ot.

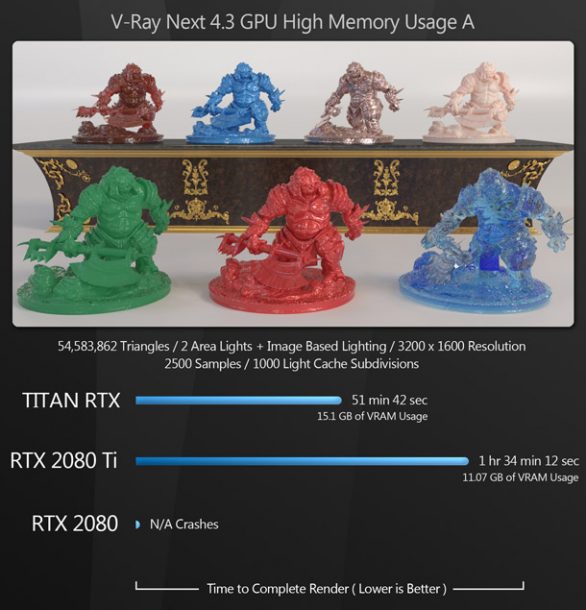

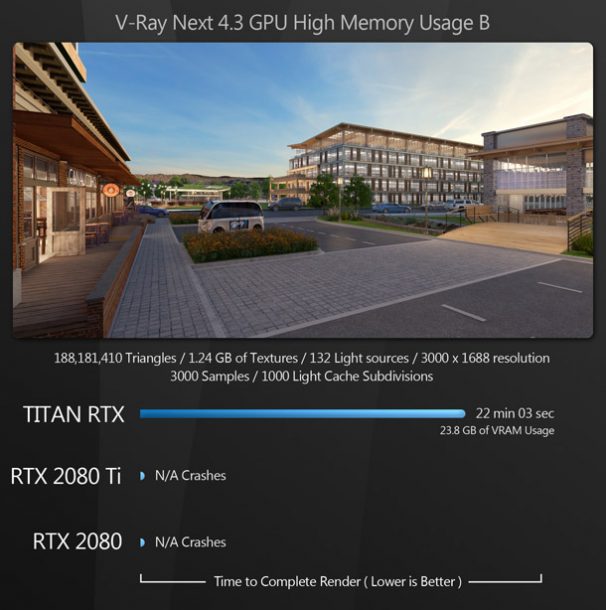

A GPU rendering benchmark-jait vizsgálva felmerülhet a kérdés, hogy miért költene valaki 2500 dollárt egy Titan RTX-re, amikor a GeForce RTX 2080 Ti szinte ugyanolyan jól teljesít, kevesebb, mint féláron. A válasz a memóriakapacitásában rejlik. Annak szemléltetése érdekében, hogy a Titan - vagy más grafikus memóriával rendelkező GPU-k ára miért éri meg a DCC szakembereknek, felállítottam a néhány különösen komplex jelenetet. A GPU memóriahasználatának mérésére az EVGA Precision X1 hardvermonitorját használva.

Ha a GPU-nak nincs elegendő grafikus memóriája egy számítási feladathoz, akkor az adatokat ki kell küldenie a RAM-ba. Ezt magon kívüli renderelésnek hívják. Az eredményekből látható,

hogy ez sokkal lassabb, mint az VRAM elérése, illetve kevésbé megbízható.

A V-Ray "trolls" jelenetében a Titan RTX – ahol az egész jelenet befért a VRAM- ba - sokkal jobb teljesítményt nyújt, mint a GeForce RTX 2080 Ti, míg a GeForce RTX 2080 egyáltalán nem rendereli a jelenetet.

A másik két jelenetet sem a sima 2080-as, sem a 2080 Ti nem rendeli, A V-ray minden alkalommal összeomlik a látványtervezésnél, a Maya pedig „betelt memória” hibaüzenetekkel kilép az Arnoldal renderelt jelenetben.

A GeForce RTX kártyák egyik problémája az, hogy grafikus memóriájuk jelentős részét fel kell használniuk a tartalom képernyőn történő megjelenítéséhez, csökkentve ezzel a renderelésnél rendelkezésre álló memóriát. A megoldás erre, hogy két GPU-t teszünk a gépbe. A legtöbb rendermotor lehetővé teszi, hogy mi döntsük el, melyik videókártyát szeretnénk használni renderelés során a számoláshoz, tehát ha letiltjuk a megjelenítésre használt GPU-t, akkor az alkalmazás visszatér a

számolási feladatokhoz fenntartott másik GPU-hoz, melynek immár a teljes memóriája rendelkezésünkre áll a rendereléshez.

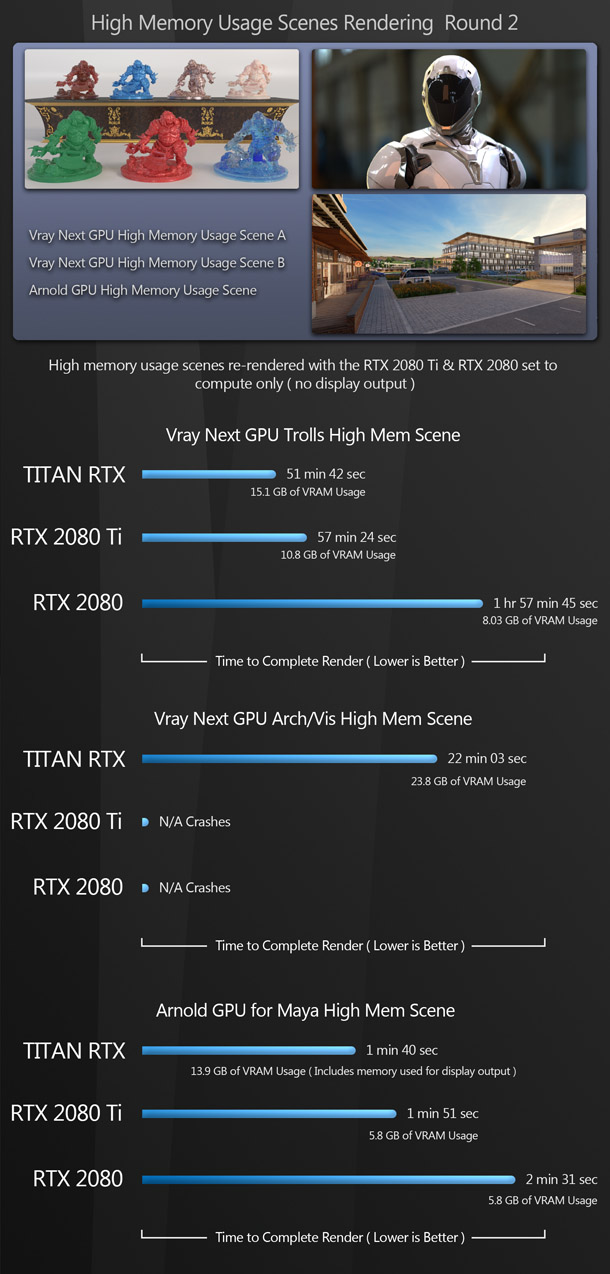

Ennek tesztelésére 3 magas memória igényű benchmark-ot futattam dual GPU beállításban, TitanRTX-t megjelenítés céljából, és az RTX 2080-t vagy RTX 2080 Ti-t rendereléshez.

Ezúttal kissé más eredményeket kaptam. A 2080 Ti, és a 2080 is renderelte V-Ray-ben a "trolls" jelenetet. A 2080-nak magon kívüli renderelésre volt szükség, ami kissé lelassította a folyamatot, de a 2080 Ti nagyon közel állt a Titan teljesítményéhez. Az eredmények hasonlóak voltak az Arnoldal renderelt Maya-s jelenethez, bár a V-Ray még mindig nem volt hajlandó kirenderelni a látványtervező jelenetet egyik GeForce kártyával sem.

Ha Titan RTX árcéduláját látva felszalad a szemöldököd, jó alternatíva két RTX 2080 Ti kártya vásárlása. Nem világos azonban, hogy a GeForce RTX GPU-k felhasználhatják-e az Nvidia NVLink technológiáját a GPU memória összegyűjtésére, ugyanúgy, ahogy a Titan RTX és a Quadro RTX kártyák (részletes elemzést ebben a cikkben találsz).

Még akkor is, ha a 24 GB-os grafikus memória némelyikét megjelenítési feladatokra használnánk, egy Titan RTX még mindig sokoldalúbb, mint két 2080 Ti, amiben csak a kiválasztott kártya grafikus memóriájának 11GB-ját használhatod renderelésre.

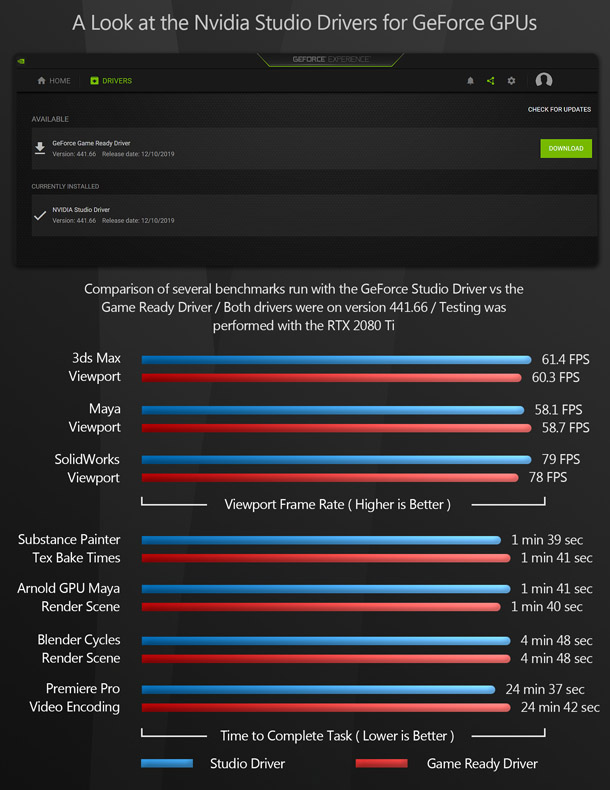

Kaptam egy kérdést arra vonatkozóan, hogy az Nvidia Studio illesztőprogramjai előnyt jelentenek-e a Game Ready illesztőprogramokkal szemben a DCC működéséhez. Ennek teszteléséhez minden

benchmark-ot RTX 2080 Ti-n futattam a Studo driver 441.66-os verziójával és Game Ready illesztőprogram 441.66 verziójával, a Wagnardsoft Display Driver Uninstaller segédprogramjával, hogy megbizonyosodjak arról, hogy tiszta telepítés történt-e az egyikről másikra való váltáskor.

A fenti eredményekből látható, hogy az illesztőprogram váltása nem befolyásolta a teljesítményt. Végeztem egy kis kutatást, és úgy tűnik, hogy a Studio illesztőprogramok célja valójában a stabilitás javítása a DCC alkalmazások használatakor, nem pedig a teljesítmény növelése. Régóta használom a GeForce GPU-kat DCC szoftverrel, és sosem voltak a stabilitással problémáim, tehát ha jelenleg a Game Ready illesztőprogramokat használsz, és minden tökéletesen fut, tanácsolom, hogy ragaszkodj hozzájuk.

Mi a tanulsága ennek a tesztnek?

Először is, a GeForce RTX 2080 Ti nagyon erős GPU a DCC munkához. Hacsak az elvégzendő feladatok nem igényelnek több, mint 11 GB-os grafikus memóriát, nagyon közel áll a Titan RTX teljesítményéhez, az ár kevesebb, mint feléért.

Továbbá, az összes Turing alapú GPU meglehetősen gyorsabb, ha olyan GPU render megoldássalhasználjuk, mely kihasználja a hardveres raytracing magokat.

És végül: az Nvidia Studio illesztőprogramjai csekély hatással vannak a DCC alkalmazások teljesítményére. Nem rontják a teljesítményt, javíthatják a stabilitást, tehát nincs ok arra, hogy ne használd őket: csak ne számíts a teljesítmény jelentős növekedésére.

Végül köszönetet szeretnék mondani, hogy időt szakítottál a cikk elolvasására. Remélem, hogy hasznos és informatív volt. Ha bármilyen kérdésed vagy javaslatod van, tudasd velem a megjegyzésekben.

Jason Lewis Senior Environment Artist az Obsidian Entertainment-nél és CG Channel’s rendszeres rovatírója. Az ArtStation galériájában láthatod további munkáit.